Gehört zu: Teleskope

Siehe auch: Nachführung, Aufnahmeverfahren, Orion ED80/600, Barlow-Linse, ZWO ASI 294MC

Benutzt: Fotos von Google Drive, Tabellenblatt von Google Drive

Stand: 14.10.2023

Auflösungsvermögen eines Teleskops

Das sog. Auflösungsvermögen eines Teleskops bedeutet, welche kleinen Einzelheiten noch getrennt dargestellt werden können (deswegen auch “Trennschärfe” genannt). Das hängt von der Öffnung des Teleskops ab.

Siehe: http://www.clearskyblog.de/2009/09/22/mathematik-in-der-astronomie-teil-4-das-aufloesungsvermoegen-von-teleskopen/

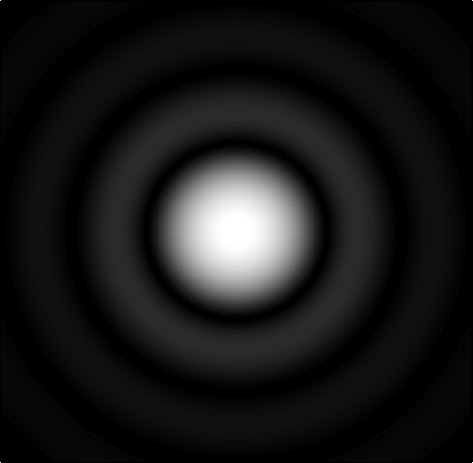

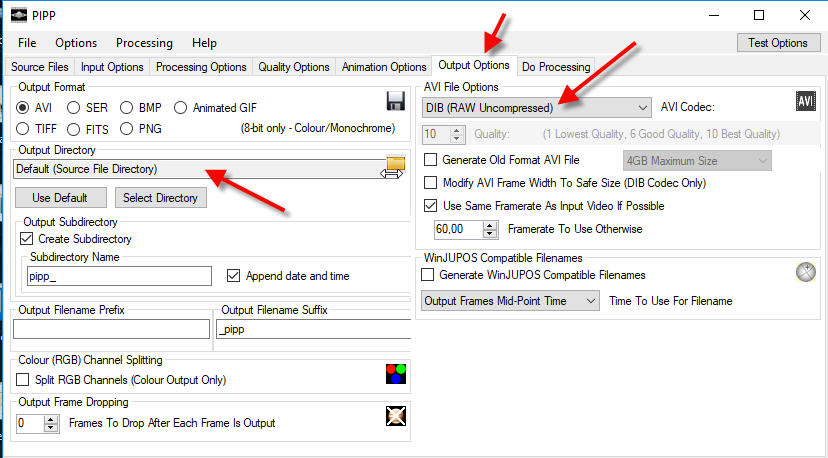

Beugungsscheibchen (Airy-Scheibe)

Das Abbild einer punktförmigen Lichtquelle (ein Stern) ist im Teleskop ein Beugungsmuster mit einem Beugungsscheibchen in der Mitte das Maximum.

Der Radius des Beugungsscheibchens, gemessen bis zum ersten Minimum, ist (in Bogensekunden) ist nach George Airy:

(1) α = 1,22 * (λ /D) * 206265 [arcsec]

wobei

- 206265 = 360 * 60 * 60 / 2π

- λ die Wellenlänge des Lichts [nm],

- D die Öffnung des Teleskops [mm] ist

Die 1,22 ergibt sich aber als die erste Nullstelle der Besselfunktion (s.u.), die für den Radius des ersten Beugungsminimums zuständig ist.

Zur sich daraus ergebenden Berechnung des Auflösungsvermögens (s.u.) lassen Teleskop-Verkäufer gern den Faktor 1,22 weg, um zu besser aussehenden Werten zu kommen.

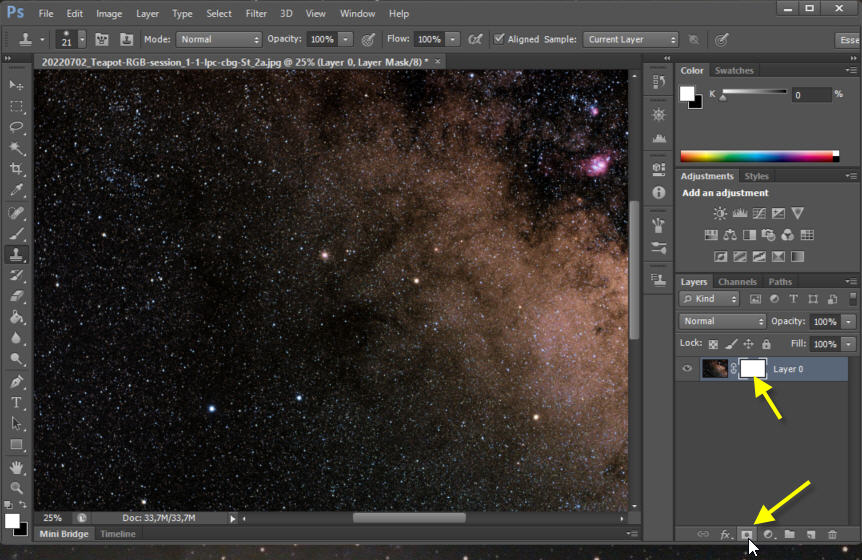

Abbildung 1: Ein Beugungsscheibchen (pCloud: Diffraction_disc_calculated.jpg)

Beugungsscheibchen (Wikimedia KaiMartin CC BY-SA 3.0)

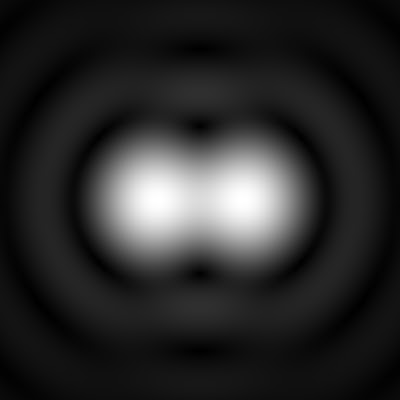

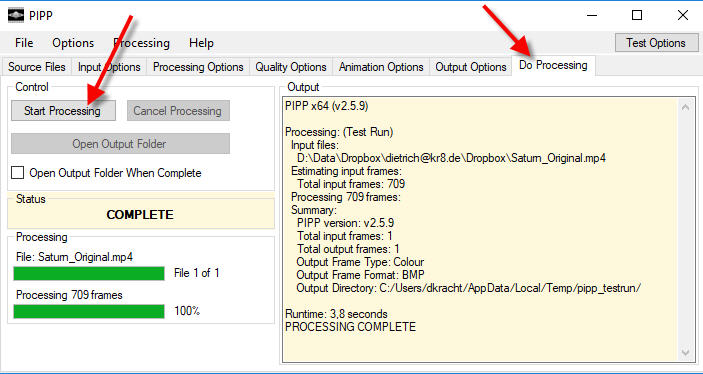

Auflösungsvermögen: Rayleigh-Kriterium

Die Frage ist nun, wie dicht dürfen zwei solche Beugungsscheibchen zueinander stehen, sodass wir sie immer noch als zwei getrennte Objekte erkennen können?

Das sog. Rayleigh-Kriterium besagt, dass der minimale Abstand zweier Lichtpunkte, der noch eine Trennung ermöglicht, dann erreicht ist, wenn der Mittelpunkt des zweiten Lichtpunkts genau im ersten Minimum des Beugungsmusters des ersten Lichtpunkts liegt.

Dieses Rayleighkriterium ist physikalisch nicht wirklich begründet. Wenn ich die Lichtpunkte ein klein wenig näher aneinander rücke, wird die Trennbarkeit ja nicht plötzlich aufhören. Aber so Pi mal Daumen passt es schon.

Abbildung 2: Zwei Beugungsscheibchen (pCloud: Airydisks_rayleigh_sqrt.jpg)

Rayleigh Kriterium – Copyright WikiMedia Geek3 CC BY-SA 3.0

Wenn wir als Lichtwellenlänge λ annehmen 550 nm (grün), ergibt sich als Faktor

1,22 * 550 nm * 206265 = 138403815 nm

und damit folgende (theoretische) Faustformel für den Radius des Beugungsscheibchens und damit (nach Rayleigh) für das Auflösungsvermögen:

(2) Auflösungsvermögen [“] = 138 / D [mm]

Gerechnet mit dieser Faustformel ergibt sich:

Tabelle 1: Auflösungsvermögen

| Teleskop |

Öffnung in mm |

Auflösungsvermögen in “ |

| GuideScope50 |

50 |

2,76″ |

| LidlScope |

70 |

1,98″ |

| Orion ED 80/600 |

80 |

1,73″ |

| APM APO 107 |

107 |

1,29″ |

| Vixen 114/900 |

114 |

1,21″ |

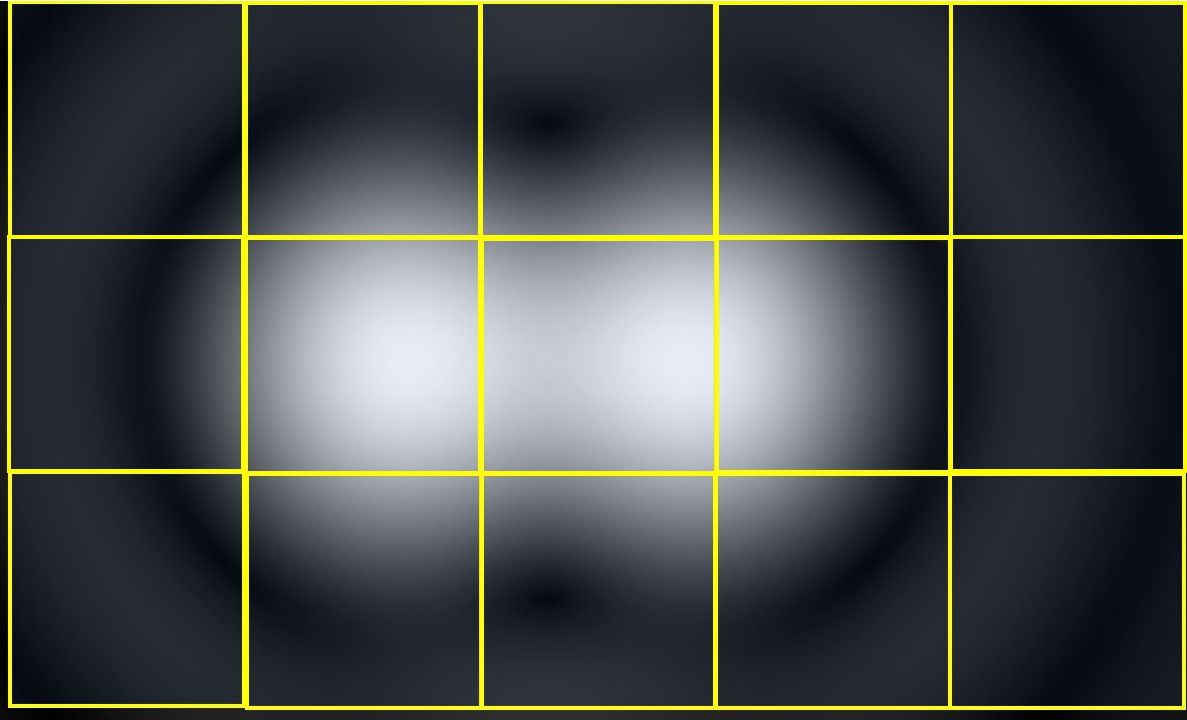

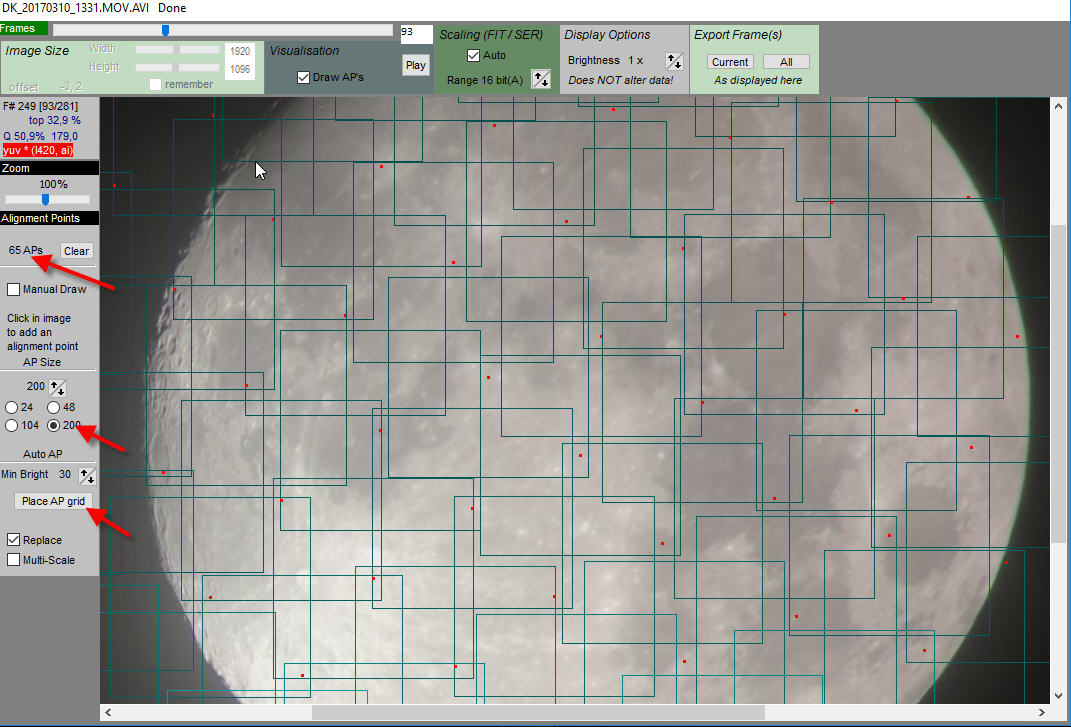

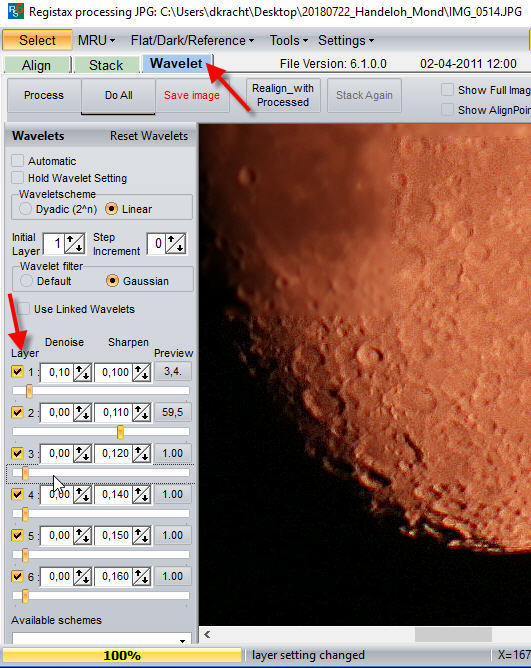

Abtast-Theorem von Nyquist und Shannon

Nun fällt dieses analoge Bild (s.o.) ja auf den Sensor unserer Kamera. Der Sensor besteht aus (diskreten) Pixeln. Der Sensor ist also digital.

Wir haben es also mit der Wandlung eines analogen Signals in ein digitales Signal zu tun.

Die digitale Pixel-Matrix tastet sozusagen das analoge Bild ab.

Hier wird immer gern das Abtast-Theorem (= Sampling Theorem) von Nyquist und Shannon herangezogen. Das sagt, im Prinzip sollte die Abtastfrequenz mindestens 2-mal so groß sein, wie das kleinste Detail im analogen Signal, sprich also wie die Auflösung.

Siehe dazu etwa: http://www.nightskyimages.co.uk/sampling_rate.htm

Das ist intuitiv ja auch klar, wie folgendes Bild veranschaulicht:

Abbildung 3: Nyquist Sampling Theorem (pCloud: Nyquist-01.jpg)

Nyquist Abtasttheorem

Nyquist

Pixelgröße und Brennweite

Oft wird die Frage gestellt, welche Pixelgröße die Aufnahmekamera (der Sensor) bei gegebener Teleskopbrennweite haben sollte. Hierzu folgende Betrachtung: Zwei Objekte lassen sich auf dem Sensor nur dann trennen, wenn zwischen ihnen ein weiterer Pixel liegt. Der Abstand dieser Objekte auf dem Sensor-Chip beträgt also das Zweifache der Pixelgröße (2 x p).

Bei der Astrofotografie muss man die absolute Größe des Beugungsscheibchen (von der Optik) in Relation zur Pixelgröße des Sensors setzten. Die absolute Größe des Beugungsscheibchens hängt dabei von der Brennweite (f) und der Öffnung (D) des Teleskops ab, bzw. bei längerer Belichtung vom Seeing. Das Sternenscheibchen durch Seeing kann je nach Luftunruhe 2″ bis 5″ (FWHM) betragen (Link: https://sternen-surfer.jimdo.com/tipps/pixelgr%C3%B6%C3%9Fe-und-brennweite/).

Um die Durchmesser des Beugungsscheibchens mit der Pixelgröße der Kamera vergleichen zu können, rechnen wir den Winkel (Formel (1) oben) in Länge um,

Radius Beugungsscheibchen [µm] = Brennweite [mm] * 1000 * Auflösungsvermögen [arcsec] * π / (60*60*180)

Radius Beugungsscheibchen [µm] = Brennweite [mm] * 1000 * 1,22 * (λ [nm] / D [mm])

Mit der Wellenlänge λ = 550 nm bekommen wir dann:

(3) Radius Beugungsscheibchen [µm] = (f/D) * 0,671

Also spielt das Öffnungsverhältnis f/D die entscheidende Rolle:

Tabelle 2: Optimale Pixelgröße

| Teleskop |

Öffnung in mm |

Auflösungs-vermögen in “ |

Brennweite in mm |

Radius Beugungs-scheibchen in μ |

Optimale Pixelgröße in μ

|

| GuideScope50 |

50 |

2,76 “ |

180 |

2,42 μ |

1,2 μ |

| LidelScope |

70 |

1,98 “ |

700 |

6,71 μ |

3,3 μ |

| Orion ED 80/600 |

80 |

1,73 “ |

600 |

5,03 μ |

2,6 μ |

Orion ED 80/510

mit Reducer |

80 |

1,73″ |

510 |

4,28 μ |

2,1 μ |

Orion ED 80/1200

mit Barlowlinse |

80 |

1,73″ |

1200 |

10,07 μ |

5,0 μ |

| APM APO 107/700 mit Reducer |

107 |

1,29″ |

525 |

3,29 μ |

1,6 μ |

| Vixen 114/900 |

114 |

1,21 “ |

900 |

5,30 μ |

2,6 μ |

| Seeing FWHM |

|

2,00″ |

510 |

4,95 μ |

2,5 μ |

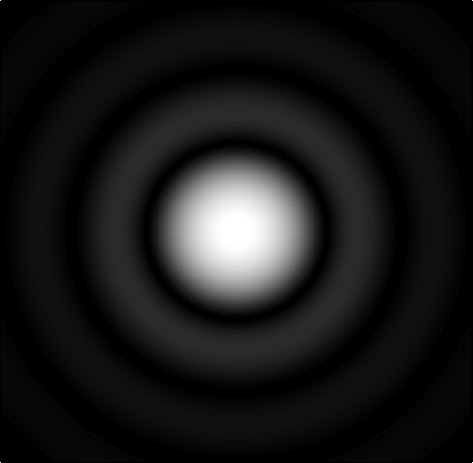

Oversampling und Undersampling

Die Pixelgröße des Sensors ist so etwas wie die Abtastrate (sampleing rate).

Abgetastet wird dabei das Beugungsscheibchen.

Bei einer zu hohen Abtastrate (kleine Pixel) spricht man von Oversampling; bei zu geringer Abtastrate (große Pixel) von Undersampling.

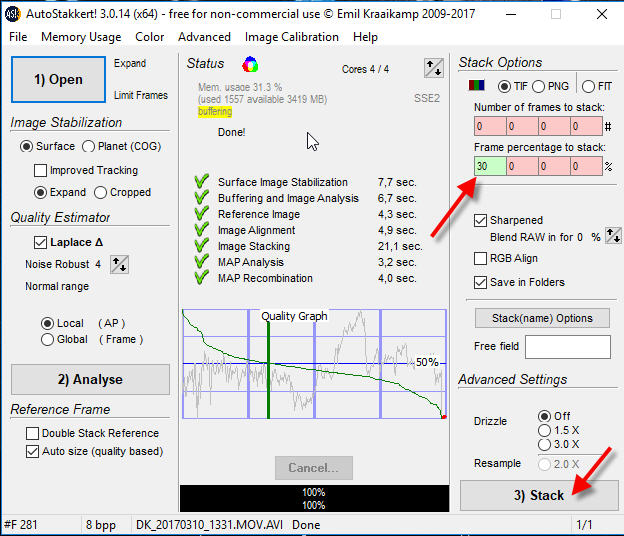

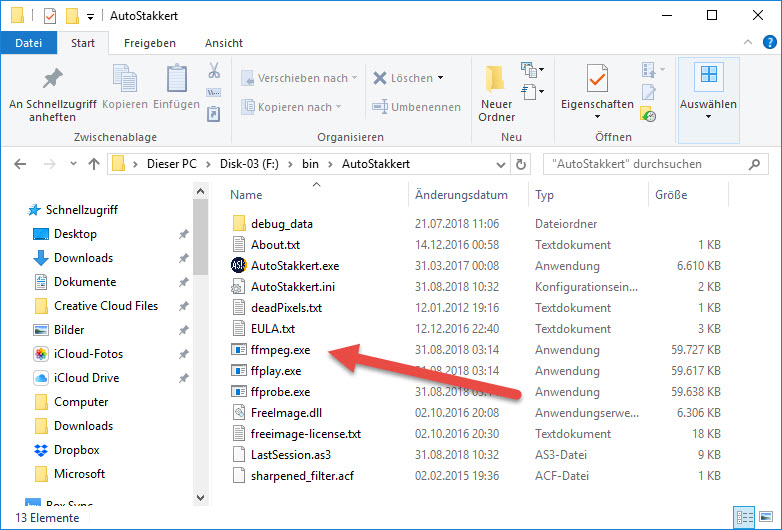

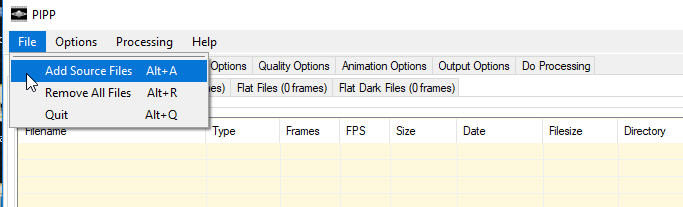

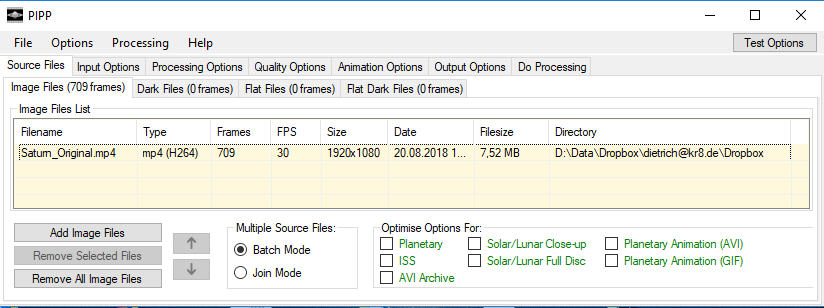

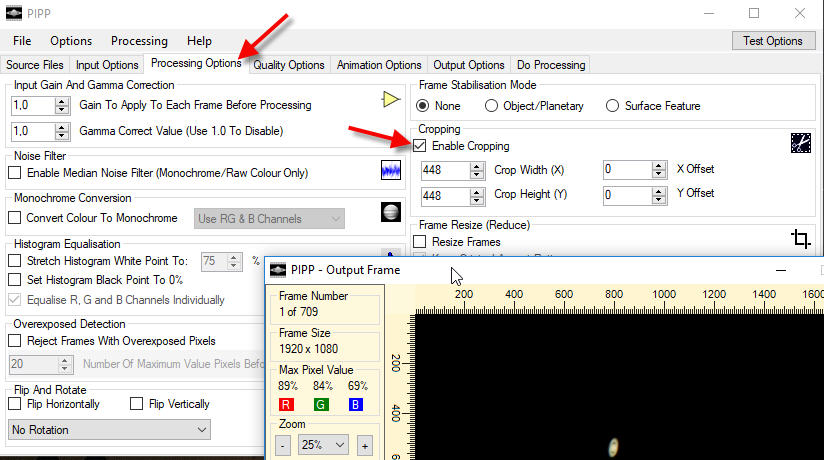

Abbildung 4: Tabellenblatt zum Sampling (pCloud: Oversampling.xls)

Tabellenblatt zum Oversampling

Für Deep Sky Astrofotografie führt ein leichtes Undersampling oftmals zu besseren Aufnahmen durch ein besseres Signal-Rausch-Verhältnis und detaillierterer Darstellung als bei Oversampling.

Für Planetenfotografie wird man je nach Teleskop versuchen, in klaren Nächten mit gutem Seeing das Auflösungsvermögen des Teleskops zu nutzen um so eher im Bereich Oversampling zu besseren Aufnahmen zu gelangen als beim Undersampling.

Wie passt die Digitalkamera mit ihrem Sensor und dessen Pixelgröße nun zu dem Teleskop?

Nach dem Nyquist-Shannon-Sampling-Theorem brauche ich einen Abstand von 2 Pixeln (also einen leeren Pixel dazwischen) um zwei Punkte zu unterscheiden. Der Abstand zwischen den Abbildungsscheibchen darf der Radius eines Scheibchens sein. Ist die Pixelgröße (viel) kleiner, spricht man von Oversampling, ist die Pixelgröße größer, spricht man von Undersampling.

Welches Öffungsverhältnis sollte ich anstreben, wenn Öffnung und Pixelgröße gegeben sind?

Mit dieser Fomel kann man auch bei gegebener Pixelgröße und Öffnung die optimale Brennweite d.h. das Öffnungsverhältnis berechnen.

(4) f/D = Pixelgröße [μ] / (1000 * 1,22 * λ [nm] )

(wenn man als Radius des Beugungsscheibchens die Pixelgröße nimmt)

Die Besselfunktion

Die Beugung an einer kreisrunden Öffnung (Lochblende) wird durch die Besselfunktion erster Art (also J) von der Ordnung 1 (also J1) beschrieben.

Die Intensität ist:

I(x) = I0 (2*J1(x)/x)2

Die ersten Nullstellen sind:

J1(3,8317)=0 und J1(7,0156)=0

Quelle: https://de.wikipedia.org/wiki/Beugungsscheibchen